로봇의 비언어적 상호작용 행위 학습을 위한 사람-사람 상호작용 데이터셋을 소개한다.

구축 배경

소셜 로봇이 사용자와 자연스럽게 소통하기 위해서는, 사용자의 행동을 이해하고 그 의도를 파악하여 적절하게 반응해야 한다. 기계학습은 이러한 로봇 지능을 구현하기 위한 한가지 방법이다. 이는 로봇에게 무엇을 해야할지 모두 알려주는 대신, 로봇이 경험을 통해 스스로 학습하고 개선하도록 한다. 소셜 스킬 또한 사람과 사람이 상호작용하는 것을 보면서 간접 경험으로 학습할 수 있다. 그러나 다양한 상황에서의 상호작용을 배우기에는 공개된 사람-사람 상호작용 데이터셋이 매우 부족하다. 또한 우리는 고령자 케어를 위한 서비스 로봇을 타겟으로 하는데 이를 위한 데이터셋은 전무한 상황이다. 따라서 우리는 소셜 로봇의 비언어적 행위를 학습시키기 위한 사람-사람 상호작용 데이터셋을 구축하였다. 샘플 데이터와 이를 확인하기 위한 Python 스크립트를 https://github.com/ai4r/AIR-Act2Act 에서 다운로드 받을 수 있다.

본 데이터셋은 다음과 같은 차별점이 있다.

- 고령자를 대상으로 한 유일한 상호작용 데이터셋임;

- 로봇 학습을 위한 로봇 데이터를 제공함;

- 3D 스켈레톤 데이터를 제공하는 가장 규모가 큰 상호작용 데이터셋임;

- 소셜 스킬 학습 뿐만 아니라 행위 인식 알고리즘을 검증하기 위한 용도로도 사용할 수 있음.

데이터셋 요약

| 총 샘플의 개수 | 5,000 셋 (각 세트는 세 개의 시점에서 촬영) |

| 상호작용 시나리오 수 | 10 |

| 참여자 수 | 고령자 100명, 일반 성인 2명 |

| 수집 환경 | 1) 아파트, 2) 노인복지관 |

| 수집 데이터 포맷 | RGB video, depth map, body index, 3D skeleton, Robotic data |

| 촬영 카메라 | Kinect v2 |

상호작용 시나리오

우리는 참여자들에게 각 상호작용 시나리오를 변형을 주어가며 다섯번씩 수행하도록 요청했다. 각 상호작용 시나리오는 두 행동의 쌍으로 정의되는데, 하나는 고령자(E)가 수행하는 시작 행동이며, 나머지 하나는 일반 성인(R)이 수행하는 반응 행동이다. 시작 행동은 8개의 인사 행동과 2개의 추가 행동(하이파이브, 때리려하기)로 구성하였다. 반응 행동은 서비스 로봇이 수행하였을 때 자연스럽우며 사람들이 수용할 수 있는 행동으로 구성하였다. 이 때, 참가자들에게 어떻게 행동해야 하는지 정확히 지시하지 않았기 때문에 매번 행동이 조금씩 다르다.

| 1 | E: 문을 통해 서비스 영역으로 들어온다. R: 노인에게 허리 숙여 인사한다. |

| 2 | E: 목적없이 서 있다. R: 노인을 쳐다보며 지시를 기다린다. |

| 3 | E: 로봇을 부른다. R: 노인에게 다가간다. |

| 4 | E: 로봇을 계속 쳐다본다. R: 어색함에 머리를 긁적인다. |

| 5 | E: 악수하려 팔을 든다. R: 노인과 악수한다. |

| 6 | E: 얼굴을 가리고 운다. R: 손을 뻗어 노인을 안아준다. |

| 7 | E: 하이-파이브하려 팔을 든다. R: 고령자와 하이-파이브 한다. |

| 8 | E: 로봇을 때리려 위협한다. R: 두 팔을 들어 얼굴을 가린다. |

| 9 | E: 저리가라고 손짓한다. R: 돌아서서 서비스 지역을 떠난다. |

| 10 | E: 돌아서서 문으로 걸어간다. R: 고령자에게 허리 숙여 인사한다. |

수집 환경

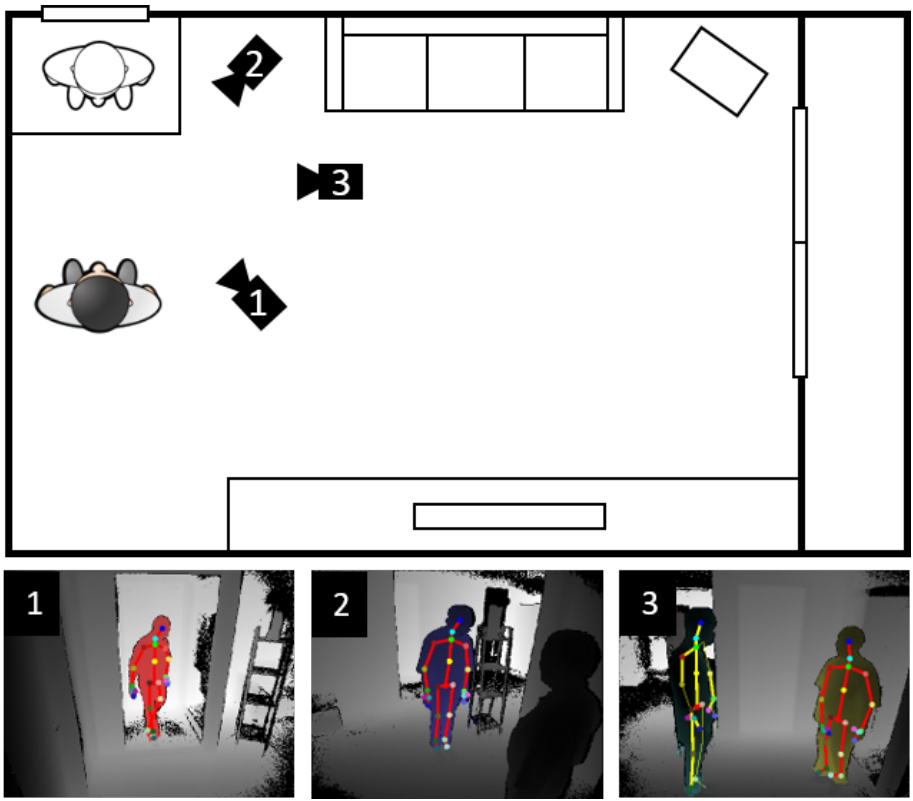

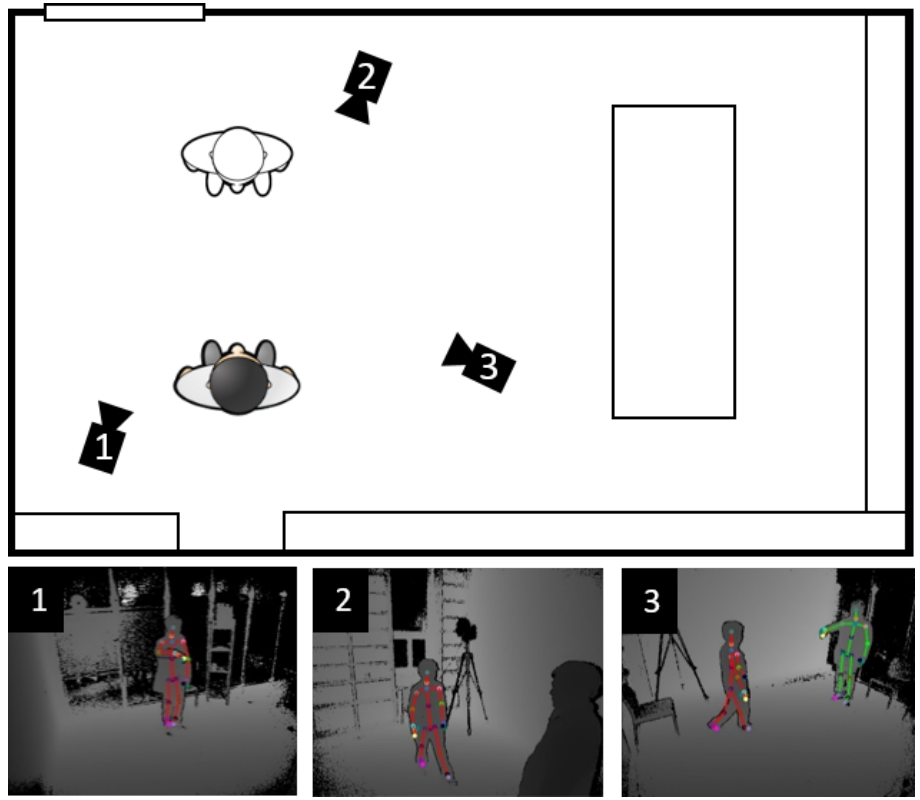

본 상호작용 데이터는 서비스 로봇이 주로 사용되는 아파트 주거 환경과 노인복지관에서 각각 수집되었다. 각 시나리오 촬영을 위해 세 대의 카메라를 같은 높이로 설치하였으며. 시나리오마다 행동 반경이 다르므로 조금씩 이동하며 촬영하였다. 이 때, 두 대의 카메라는 각 사람의 시점에서 다른 사람의 행동을 촬영하였으며, 나머지 한 대의 카메라는 두 사람의 상대적인 정보를 수집하기 위해 두 사람 모두가 보이는 위치에서 촬영하였다. 이처럼 세 개의 다른 시점에서 5,000 세트의 상호작용 샘플을 수집하였으며, 각 영상은 6초 정도의 길이이다.

- 아파트 환경

- 노인복지관 환경

수집 데이터

| 데이터 종류 | 해상도 | 파일 포맷 | |

|---|---|---|---|

| RGB video | 1920 X 1080 | AVI | 45.37 GB |

| Depth map | 512 X 424 | PNG | 472.07 GB |

| Body index | 512 X 424 | PNG | 2.12 GB |

| 3D skeleton | 25 joints | JSON | 2.26 GB |

| Robotic data | 10 joint angles | JSON | 47.0 MB |

| 총 | 521.88 GB |

참조

본 데이터셋을 참조하거나 활용하시는 경우 아래의 논문을 인용해 주시기 바랍니다.

Woo-Ri Ko, Minsu Jang, Jaeyeon Lee and Jaehong Kim, “AIR-Act2Act: Human-human interaction dataset for teaching non-verbal social behaviors to robots,” arXiv preprint arXiv:2009.02041, 2020. arxiv

다운로드

아래 링크를 따라 회원으로 가입하여 다운로드 페이지로 이동하시기 바랍니다.

담당자 연락처

- 이름: 고우리 선임연구원

- 이메일: wrko@etri.re.kr

- 전화번호: 042-860-6482

- 소속: 한국전자통신연구원 지능로보틱스연구본부 인간로봇상호작용연구실

사사

본 데이터셋은 개인정보보호와 안전한 데이터의 획득/관리를 위해 기관생명윤리위원회(IRB: Institutional Review Board)의 승인을 거쳐 구축되었습니다.

본 데이터셋은 과학기술정보통신부 산하 정보통신기획평가원의 “고령 사회에 대응하기 위한 실환경 휴먼케어 로봇 기술 개발(2017-0-00162)” 사업의 일환으로 구축되었습니다.